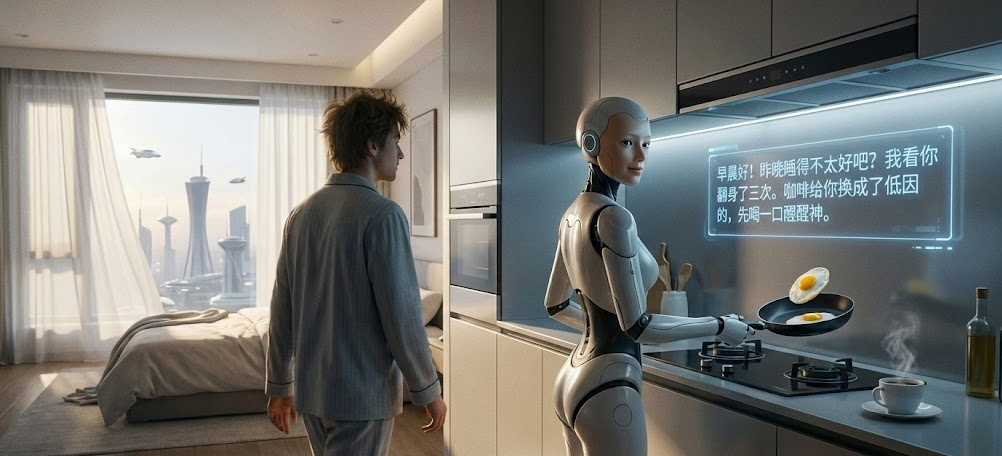

2035年,中国北京,早晨七点。闹钟还没响,窗帘已经悄无声息地拉开了一条缝,让一缕柔和的阳光唤醒你的眼睛。厨房里传来了轻微的滋滋声,那是煎蛋刚下锅的声音。

你迷迷糊糊地走出卧室,并没有看到家人忙碌的身影,站在灶台前的,却是一个外形优雅的人形机器人。它正用灵巧的双手翻动锅铲,力度拿捏得恰到好处。看到你出来,它微微侧过头,覆盖仿生皮肤的容貌让人舒适而信赖。它用带着几分关切语调的声音说:“昨晚睡得不太好吧?我看你翻身了三次。咖啡给你换成了低因的,先喝一口醒醒神。”

注:画面由AI生成

注:画面由AI生成

这一幕,曾无数次出现在这一百年的科幻作品里。从阿西莫夫的《我,机器人》到电视剧《西部世界》,人类对于人造人的想象从未停止。但站在2025年向未来眺望,你会发现,这不再是遥不可及的幻想,这个画面正在从银幕走向现实。

现在,全球机器人实验室与工厂,都投身在具身智能的热潮里。从工业流水线上的机械臂,进化到有望走进千家万户的“家庭成员”,人形机器人正在经历一场脱胎换骨的进化。现在,科学家们正试图给这些钢铁之躯,装上智慧的大脑、敏捷的身体、灵巧的双手、以及高效的通信,来完成这最后几公里的跨越。

一、具身智能:从纸上谈兵到身体力行

这一两年,ChatGPT这类大语言模型的出现,确实让大家惊艳了一把。它们能写诗、能写代码,甚至能分析你的感情问题。但是,哪怕是最聪明的大语言模型,如果你让它把桌上倒了的酱油瓶扶起来,它也束手无策,因为它没有物理世界中的身体。这就是机器人圈子里最近最火的概念:具身智能。通俗来说,过去的大语言模型是“缸中之脑”,它活在服务器里,懂天文地理,却没摸过哪怕地上的一捧泥土。而具身智能,就是要给这个大脑装上躯干和四肢,让它去物理世界里探索学习与进化。

这事有多难?机器人领域有个莫拉维克悖论:让计算机在下棋、算数上赢过人类非常容易;但要让机器人像一岁孩子一样,在乱糟糟的客厅里走一圈不摔跤、顺手把地上的玩具捡起来,却非常困难。

因为真实世界太复杂了。地毯可能有褶皱,光线可能忽明忽暗,猫可能突然窜出来。这些对于人类来说是本能的反应,对于机器人来说,却需要复杂而巨量的计算。

然而,大模型技术的突破让我们看到了希望。国外的Physical Intelligence公司提出的π*0.6大模型,让机器人综合学习机器人遥操与人类操作的数据集,学习好的家务机器人可以在旧金山办公室里为同事们制作拿铁、美式咖啡和意式浓缩咖啡,并且连续13小时,中间只有几次中断。

Physical Intelligence做咖啡机器人[1]

而在国内,诸多科技公司则利用虚实迁移的技术来训练,即用AI生成海量的、逼真的三维虚拟物体和场景。在这个拥有亿级数据的虚拟练功房里,机器人可以不分昼夜地针对各种奇形怪状的物体进行抓取训练。它不用人教,也能稳稳拿捏各种操作技能。

因此,这种让AI通过身体去感知、去学习的方式,才是机器人通往家庭的真正门票。

二、机器人的运动技能:从学公式到练直觉

有了聪明的脑子,还得有灵巧的身体。在制造机器人本体这件事上,全球工程师们正经历着一场观念的转变。

大家大概记得波士顿动力那个著名的液压机器人阿特拉斯。它能后空翻、能跑酷,但它有个致命弱点:液压系统,其安全性、噪声、成本都使得其被家用场景拒之门外。所以,发生了一个标志性事件:波士顿动力淘汰了液压的阿特拉斯,转投了全电驱动的怀抱。这一转折背后,是全球技术路线的殊途同归:为了进家庭,机器人必须更安静、更高效、更像人。国内的企业是这一波浪潮里的排头兵,他们做的人形机器人,被人踹了一脚还能晃晃悠悠站稳,稳健得像个练家子,甚至还能够进行空翻等高难度动作。

在这背后,是运动控制算法的革命——强化学习。以前让机器人走路,工程师得写一堆复杂的微分方程,规定它左腿抬高20度,右腿前移10厘米。这种死记硬背的方式,一遇到地面不平或者被人撞一下,机器人就因为算不过来而死机倒地。现在的做法完全变了,不再是教它怎么走,而是让它自己练。工程师把机器人扔进物理仿真引擎里,利用强化学习算法,给它设定一个简单的目标:往前走,别摔倒。起初,机器人像婴儿一样蹒跚学步,但在数亿次的虚拟试错中,它为了获得奖励,自己摸索出了一套保持平衡的肌肉记忆。这就像人类学骑自行车,你很难用公式解释怎么保持平衡,全是靠小脑的本能反应。

三、灵巧手:机器人中的钢琴家

如果说具身智能给了机器人大脑,运动控制给了它双腿,那么灵巧操作技术,就是为了给它一双能干细活的手。

在工厂里,机械臂往往只需要一个简单的两指夹爪。但在家里,机器人要面对的是松软的面包、易碎的鸡蛋、以及家电上形态各异的按钮。为了衡量机器人这双手的操作能力,北京邮电大学人工智能学院提出了一个从L0到L5的进化阶梯,这正是机器人从专用工具迈向通用智能体的必经之路。

最初级的L0级,就像是一个蒙着眼睛的熟练工。它动作精度极高,但只要零件稍微歪了一点,它就失效了;到了L1级,机器人长了眼睛,通过摄像头,它能看见杂乱货箱里的快递盒,并准确抓取;L2级则是视觉触觉的融合,这时候的机器人不仅能看,手指上的触觉传感器还让它有了分寸感,抓鸡蛋时轻拿轻放,抓哑铃时大力紧握;L3级的机器人不再是简单的夹取,而是多个关节协同运动,比如拧瓶盖、叠衣服,这需要手指间以及双手的配合;L4级的机器人能像我们一样,握住锤子去钉钉子,握住螺丝刀去修家电,这要求它不仅要感知自己的手,还要感知工具末端与环境的交互;最后的L5级则是拟人双手的通用操作。这一阶段的机器人拥有一双媲美人类的双手,且具备了自我进化的能力。面对一道从未做过的菜,它不需要工程师重新写代码,而是可以通过看一遍人类大厨的演示视频,利用模仿学习和强化学习,自己领悟切菜、颠勺的动作要领。

四、语义通信:机器人神经系统的高速公路

要让机器人看得清、听得懂、动得快,这背后需要处理的数据量是大得惊人的。试想,如果机器人要把看到的每一帧超高清画面、每一毫秒的触觉反馈都传到云端的智能大脑中去计算,家里的光纤宽带恐怕早已经阻塞了。

这个问题,北京邮电大学张平院士团队走在了世界前列。他们针对6G和未来智能网络提出的语义通信理论与方法,让机器人通信具备理解能力。举个例子:假设你正在出差,想通过手机远程连接机器人查看家里小猫的情况,但此时网络信号很差,只剩一格。如果是传统通信,机器人拼命传输高清摄像头拍摄到的所有视频,结果只能是画面卡顿、马赛克严重;但如果用语义通信,机器人理解了你的需求,就会在家里先看懂画面找到小猫,然后发送非常简洁的画面摘要关键信息。你的手机接收后,就会用语义通信还原出一个和现实语义一致的流畅画面。

这种传神而不传形的技术,不仅仅是省流量,更重要的是它让机器之间的沟通变得智能,为未来机器人互联铺平了道路。

五、群体智能:生活的服务军团

人形机器人也有其功能上的短板:它洗衣服洗碗很慢,也无法钻到沙发下去打扫卫生。所以,未来的家庭服务,不是超级英雄的独角戏,而是一场集团化的作战。人形机器人,就是这支军团的指挥员。

想象一下这个画面:晚餐后,人形机器人收拾好餐桌,把脏碗筷整齐地码进洗碗机,然后发送一道指令,洗碗机随即启动标准清洗模式。紧接着,它发现客厅地毯上有些饼干碎屑,但那个角落它自己走过去太费劲,于是通过语义通信,它向角落里的扫地机器人下达了定点清洁的命令。

这就是群体智能在家庭里的真实模样:人形机器人如同前线指挥,负责统筹现场情况,各智能体共同构建起分布式计算网络,通过语义通信实现即时、高效的战术协同。这种群体智能协同机制,将原本分散的家电变成了一个有机的家庭服务生态,把我们的生活打理得井井有条。

从1959年第一台工业机器人的诞生,到如今百花齐放的智能机器人行业,机器人的发展经历了漫长的岁月。随着产业链的成熟,它们的造价将从现在的几十万、上百万,下探到一辆国产新能源汽车的价格水平——让每个家庭像买车一样买一群机器人,将不再是空谈。

未来的群体机器人不会是抢走工作的竞争者,它们把我们从琐碎的洗碗、扫地中解放出来,让我们有时间去陪家人分享一本书,或者在周末走进大自然。等到那一天真的来临,我也许会对它说一句:“嘿,朋友们,欢迎回家。”

本文为科普中国·创作培育计划扶持作品

作者:北京邮电大学 许文俊 方斌 王心舟 张平

审核:梁忠伟 广州大学机械与电器工程学院 教授

出品:中国科协科普部

监制:中国科学技术出版社有限公司、北京中科星河文化传媒有限公司

来源: 科普中国创作培育计划

内容资源由项目单位提供

科普中国公众号

科普中国公众号

科普中国微博

科普中国微博

帮助

帮助

科普中国创作培育计划

科普中国创作培育计划