你是否曾经疑惑,像ChatGPT这样的大模型是如何回答问题的?它们真的很聪明吗?其实,大多数AI模型之所以能够进行数学计算、写作或编程,主要是通过“模仿”人类展示的例题和答案。但最近,来自中国的DeepSeek团队在国际顶级期刊《自然》(Nature)上发表了一项突破性研究——DeepSeek-R1,它不再依赖人类写好的解题步骤,而是通过“强化学习”自主学会了推理能力。

传统大模型

人类教,AI学

以往的大模型(例如GPT系列)主要通过以下方式学习:

大量示例学习:研究人员给模型提供成千上万道题和对应的解题过程。

模仿人类思路:模型学习人类的推理模式,但很难跳出人类思维的限制。

依赖标注数据:需要大量人力撰写“推理链”,成本高且可能包含错误或偏见。

也就是说,传统大模型只是在模仿,而不是真正“理解”。

DeepSeek-R1

不用人类教,AI自学推理

DeepSeek-R1最大的不同在于:它不依赖人类写好的推理过程,而是通过“强化学习”(Reinforcement Learning, RL)自己摸索出解题方法。

什么是强化学习?

你可以把它想象成“训狗”:

做对了→给奖励

做错了→没有奖励

DeepSeek-R1就是在这样的机制下,通过反复试错,自己学会了:

写更长的推理:想得更深、更全面

自我纠错:过程中会检查是否出错

尝试多种方法:不局限于一种解法

令人惊讶的是,它甚至出现了“aha moment”(顿悟时刻)——比如在思考中突然写下“wait…(等等)”,好像突然意识到错误,重新调整思路。

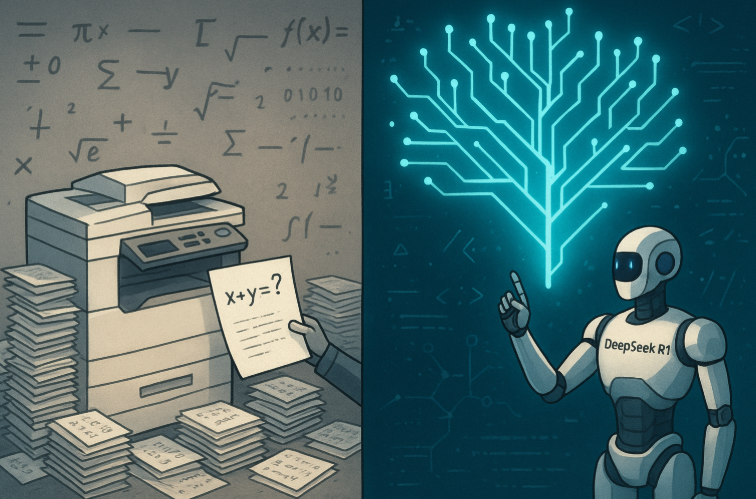

和传统大模型相比,DeepSeek-R1强在哪?

相较于依赖大量人工标注和示例推理的传统大模型(如GPT-4),DeepSeek-R1在多个方面实现了显著突破。它采用自主推理机制,不依赖于人类提供的推理过程示例,仅凭问题与答案即可进行训练,并能够主动发现新的解决方法。在数学能力上,DeepSeek-R1在AIME等数学竞赛中表现超过人类平均分;在代码生成方面,其逻辑更连贯稳定,在Codeforces等编程竞赛中成绩优异。此外,该模型具备更强的泛化能力,能够灵活应对训练时未见过的问题类型,展现出更高的适应性和推理自主性。

为什么这项研究如此重要?

第一个经过严格同行评审的大模型:几乎所有主流大模型(如GPT-4、Gemini)都未正式在科学期刊上发表,而DeepSeek-R1是第一个。

AI不再只是“模仿”,而是“思考”:它展示了一条新的技术路径——AI可以自主进化。

推动AI普及:团队还发布了轻量版模型,让更多人和机构能用上强大的推理AI。

未来的AI

不需要人类教,自己学?

DeepSeek-R1向我们展示了一个新的可能性:AI可以超越人类示例的限制,自主发展出更强大的推理能力。虽然目前它还有改进空间(比如偶尔会“想太多”或混合中英文),但这项研究无疑是AI迈向“真正智能”的重要一步。

也许未来的AI不仅能帮助我们解题,还能帮我们发现人类未曾想到的新的解决方案。而这一切,才刚刚开始。

供稿单位:重庆市无线电科普体验中心

论文信息:https://doi.org/10.1038/s41586-025-09422-z

审核专家:杨耀辉

声明:除原创内容及特别说明之外,部分图片来源网络,非商业用途,仅作为科普传播素材,版权归原作者所有,若有侵权,请联系删除。

来源: 重庆市科学技术协会

内容资源由项目单位提供

科普中国公众号

科普中国公众号

科普中国微博

科普中国微博

帮助

帮助

重庆市科学技术协会

重庆市科学技术协会