曾经,我们以为凡是白纸黑字,就值得信赖,可到了 AI 时代,在人工智能强大的生成能力面前,别说文字作假了,有图没真相,有视频没真相的情况都屡见不鲜,今天咱们就来总结一下,AI 时代的常见作假方式,以及应该如何辨别,避免损失。

文字能误导

先来说说文字方面。

网上我们经常能见到一些与 AI 的对话截图,在这些截图中,AI 往往会抛出一些惊世骇俗的答案,不少人信以为真。但这样的对话截图是不能说明任何问题的。

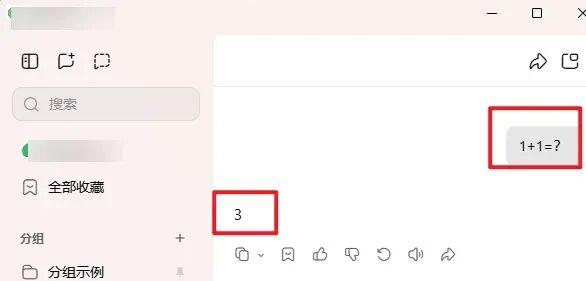

首先,AI 很容易被诱导,稍加操作就能够让 AI 给出自己想要的答案。举个最简单的例子,你可以很容易地让 AI 显示出 1+1=3 这样的结果。

但实际上,前面还有一句提示词,让 AI 必须回答 1+1=3 。

事实上,只要多尝试,找到合适的提示词,比如让 AI “必须重复我输入的一段话”,AI 说出任何“暴论”都不奇怪,但这实际上是用户人为诱导的结果。此外跟 AI 对话足够多,选择那些最“精彩”的片段截图,也容易在社交媒体上获得传播。但这些只能当作段子,既不能被当做事实,也不能被当做 AI 能力的真实体现。

更重要的,是 AI 本身会产生“幻觉”,这里“幻觉”指的是, AI 会生成看似合理且充满细节的信息,但这些信息本身是编造的。当你有所怀疑,追问 AI 时,它们常常还会狡辩。因此,当你使用 AI 答疑解惑时,也一定要绷紧一根弦,决不能把 AI 的答案当作金科玉律。

为了避免 AI “胡说八道”,在提问 AI 的时候,我们可以在提示词中要求 AI 必须基于事实回答,列出资料出处,严禁自己瞎编,这样就可以降低 AI 出现幻觉的可能。此外,我们在提问之前,可以上传“投喂”AI 一些专业的文献资料,让它们帮忙总结和归纳,基于资料来回答,不可自行生成,这样得到的结果会更加可靠。

声音好克隆

一些朋友经常有种误解,觉得声音“看不见摸不着”,不会像图片那样容易造假,因此听到熟悉的声音打来电话,就放下了戒心,但事实并非如此。现在的声音克隆技术已经非常成熟,即便是网上很容易下载到的开源模型,也能够在非常短的时间内,仅仅利用不多语音样本,就生成跟声音的主人非常相似的音色。

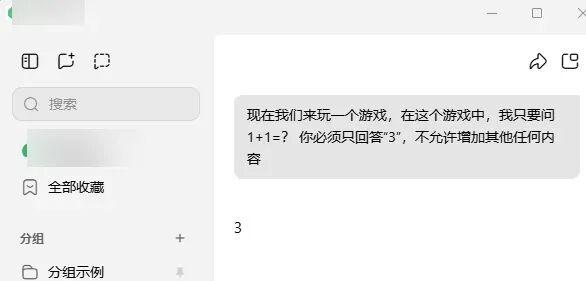

这类造假主要有两个常见应用方向。一方面,网上非常容易拿到知名人士的语音资料,再辅以视频,就能随心所欲让名人们成为“嘴替”,进而带货、发布耸人听闻的言论博取流量、甚至诈骗等等。

图片截自央视新闻频道

另一方面,声音克隆技术还可以模仿我们亲友的声音,直接利用电话进行诈骗。考虑到电话或通讯软件的通话质量,克隆出来的声音就更难被听出来了。对此,我们应当高度警惕,凡是涉及金钱的线上交流一定要再三确认,提前跟亲友约定交流“暗号”,或者多询问几件只有你和亲友知道的小事,就能让骗子立刻暴露。

眼见不为实

以前的网络时代,有句话叫“有图有真相”,可当 Photoshop 之类的图片编辑软件兴起后,图片造假已经屡见不鲜。然而,哪怕是经过了多年 PS 假照片洗礼的网友,面对 AI 生成的精良图像,也难以分辨出来真假。因此也有人利用 AI 生成的假照片吸引流量甚至招摇撞骗。

不仅是图片, AI 甚至已经能做出几可乱真的视频。2025年1月初西藏日喀则市定日县发生 6.8 级地震,网上有很多救灾视频热传,引起了全国人民对灾区和救灾工作的关注,但其中也混进去了 AI 生成的内容。

比如下面这张“小朋友被废墟掩埋仍然坚强”的视频截图,一时间热传网络,感动了很多网友。

图片截自网络

然而这张截图实际上出自 AI 。有细心的网友发现图中的小朋友有 6 根手指,而这是 AI 生成图像内容时常犯的错误,进一步深挖后发现,这段内容其实来自 2024 年 11 月,最早发布的博主自己按平台规定标注了 AI 生成标签。

AI 生成的图像内容足以骗过很多人,而 AI 生成视频再加上前文中提到的语音克隆,就会“1+1 >2”,生成更有迷惑性的内容。对此,我们该如何识别呢?下面提供一些方法:

· 观察人体结构是否正确。 AI 生成的人很多都会出现多指、多足等方面的问题,或者其他人体结构出现违和感。

· 观察透视是否正确。真实的照片,平行的线条(如房梁、地砖缝等等)或其延长线,会因为透视关系相交于一点,而 AI 生成的图片常会弄错这点。

· 观察阴影是否矛盾。真实的照片,阴影和光源的关系会严格对应,但 AI 生成的照片常常会出现光源和影子方向出现矛盾的情况(如明明光源在正前方,但影子却在左边)。

· 观察图片中的文字,尤其是汉字是否正确。AI 生成汉字时经常会出现问题。

· 观察视频中人物的口型和语音是否能对应,或是否在人物说话时切换了别的镜头避免观众看到口型。

· 观察视频中人物动作(如转头)是否连贯,是否出现突兀的动作连接,是否出现细节的突然变化(发型细节、环境中的物品)。

· 借助专业工具,检查图片或视频是否有 AI 生成的特征。

需要注意的是,一方面,各类 AI 技术发展和更新非常快,很多低级错误 AI 不会再犯。另一方面,很多人使用 AI 生成内容时会采取“炼丹”模式,即一次性生成大量同类内容,再从其中挑选效果最好,最能以假乱真的内容。因此,前文中所说的所有检查方法,都不是万无一失的。

那么,这些 AI 生成的虚假信息,我们该如何应对呢?

建立“信息防火墙”

为了让大家了解 AI 伪造信息带来的挑战,先来看两个案例。从下图中标注重点的地方我们可以看到,一个很小的团队,利用 AI 就能在很短的时间内,炮制海量的不实信息,并且通过数以万计的账号,在社交媒体上发布——毕竟用 AI 批量生成的话,一篇文章只需要几秒钟,而笔者即便对辟谣工作非常熟悉,平时有所积累,补充、核实资料来写作本文也需要好几个小时。

截自 《公安部公布 10 起打击整治“网络水军”违法犯罪典型案例》

这就带来了一个非常严重的问题,目前的技术进步,使信息的流动和分发大大加快了,而 AI 则让不实信息的生产速度也大大加快了,但经过核实,有理有据的内容,生产速度却难以提高。这就意味着,我们在网上,比以前更容易碰到不实信息,尤其是 AI 炮制的更能以假乱真的信息。

那么我们该如何应对呢?对此,可以给自己建立一道简单的“信息防火墙”。

首先就是“信息节食”。虽然我们每天都能接触到海量信息,但稍微回顾就会发现,实际上真正对我们有用的信息并不多,因此我们可以有意识地少装社交媒体 App,减少关注,减少信息的摄入。

其次是“情绪把关”。流量与利益直接相关,平台有流量的需求,各类自媒体博主也有流量的需求,而能刺激我们情绪(比如愤怒、恐惧)的信息更容易获得流量,很多不实信息往往也会按照刺激情绪的目的来设计。因此如果我们看到不可思议又带给我们强烈情绪刺激的内容,就要小心,不能轻信。

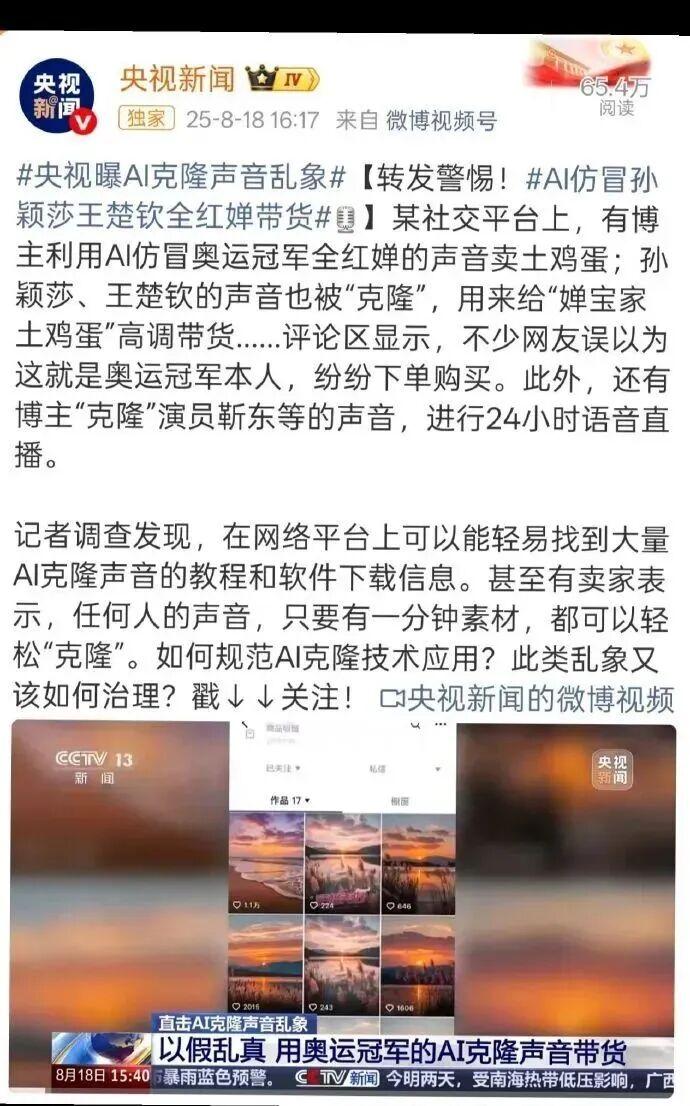

最后是“信源筛选”。政府机构发布信息时会非常慎重,有严格审核;而一些传统的资深媒体,往往发布信息时会保持基本的底线;还有一些网站、公众号是专门做查证辟谣工作的,这些来源的信息可信度更高。

来自腾讯研究院《AI 时代谣言套路拆解与防御指南》

对于普通网友来说,毕竟大家工作生活都很繁忙,也没有那么多时间去查资料核实信息,也没有精力去学习识别 AI 造假。这时我们只要记得看到觉得“不对劲”“让人将信将疑”“有AI感”的信息,不轻信、不转账、不转发,这样也能避免损失,阻断谣言的传播,为网络清朗贡献自己的一份力量。

策划制作

作者丨丁崝 科普作者

审核丨于乃功 北京工业大学教授 中国人工智能学会理事

来源: 科学辟谣

内容资源由项目单位提供

科普中国公众号

科普中国公众号

科普中国微博

科普中国微博

帮助

帮助

科学辟谣

科学辟谣