眼睛,是生命投向宇宙的第一缕目光。从人类第一次睁开双眼凝视这个世界开始,视觉就成为了我们感知环境、理解世界最重要的方式。为了突破肉眼的局限,拓展视觉的边界,精密的视觉技术愈发令人惊叹:超高速摄像机能够捕捉每秒百万帧甚至千万帧画面,让子弹飞行、水滴溅落的瞬间清晰可见;X光和核磁共振透视人体,让医生无需开刀就能洞察病灶;以及那些搭载在卫星上的遥感相机,正在从太空俯瞰地球的每一个角落。

然而有一类生物早在5亿年前就已经进化出了超越想象的视觉系统,它们无需任何精密的仪器,不依赖复杂的电路,仅凭着与生俱来的复眼结构就能实现许多我们梦寐以求的视觉功能。这就是节肢动物,一个占据地球80%以上动物物种的庞大家族。它们的复眼如同天然的生物相机阵列,由不定数量的小眼组成,可能是数个,也可能是数以千计,每个小眼都是一个独立的感光单元。

例如螳螂虾,它拥有地球上最复杂的视觉系统,能够感知12-16种基础颜色。要知道,我们人类只有三种视锥细胞,也就是说只能看到红、绿、蓝三原色的组合。再比如蜜蜂,能够看见紫外线世界里的隐形地图,这是花卉在紫外线下留下的蜜导标记,指引着蜜蜂准确找到花蜜的位置。以及令人讨厌的苍蝇,之所以轻易躲开我们的追击,都归功于复眼超强的动态视觉能力。而且,这一切都是在极低的能耗下完成的,这种能量效率令我们最先进的电子设备都望尘莫及。

那如果我们能够借鉴复眼的设计原理,结合现代人工智能技术,会不会创造出一种全新的视觉系统?一种既拥有生物复眼的灵活高效,又具备人工智能的理解能力的智能仿生眼?

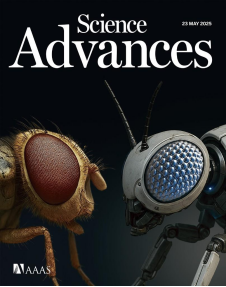

2025年5月,一项发表在《Science Advances》上的研究为我们带来了新的突破性的答案。

上海理工大学与美国杜克大学的联合研究团队成功开发了一种仿生复眼相机,以节肢动物视觉为模型,能够产生165°视角和40微米分辨率的全彩全景图像。让我们先来理解一下这些数据意味着什么。165度的视角是什么概念?我们的双眼大约只能看到120度范围内的景象,这代表着这个仿生复眼能看到我们身侧的物体。而40微米的分辨率相当于能清晰分辨出比头发丝还细一半的物体,这已经接近了许多专业显微镜的水平。

更值得惊叹的是,这个被称为BCE(Biomimetic Compound Eye,仿生复眼)的神奇装置体积仅有0.8立方厘米——比一颗方糖还要小。在这么小的空间里塞进了足足127个精密排列的小眼单元。每一个小眼都像是一台微型探测器,它们协同工作,共同构建出一幅完整的世界图景。

要制造这样一个精密的装置,传统的加工方法显得捉襟见肘,于是研究团队采用了微流控辅助的3D打印。3D打印大家已然不陌生,但普通的3D打印机打印一个茶杯可能就需要几个小时,且打印精度也就在零点几毫米。而这项研究使用的3D打印技术,能够在液体环境中进行超精密打印,精度达到了微米级别。我们头发的直径也才几十微米,而微米级3D打印技术的精度不亚于在头发丝上进行雕刻。

整个制造过程就像是微观世界的建筑工程:首先,在直径仅5毫米的半球形基底上,3D打印出127个蜂窝状排列的微型空间。然后利用液体的表面张力在每个空间里精确地形成一个完美的微透镜。而每个小眼单元都包含两个关键部件:顶部的微透镜负责聚焦光线,就像我们相机的镜头;下面的锥形光波导则像是一根根超细的光纤,负责将收集到的光线传导到底部的图像传感器。这种设计几乎完美复制了昆虫复眼的结构:在蜻蜓的复眼中,每个小眼也是由透镜和感光细胞组成的。

但这个精妙的硬件设计只是故事的一半。如果直接观察BCE相机采集的原始图像,我们可能会大失所望。BCE相机获取的原始图像呈现典型的复眼成像特征:由于127个独立小眼单元的光学视场存在重叠,单个目标在未处理的原始数据中会产生多重伪影。如图所示,一个手写数字8在视场内会形成6个重复影像,这是由仿生复眼的六旋转对称结构导致的固有现象。这种原始数据无法直接用于视觉任务,需依赖多级神经网络实现信息重构。这就是人工智能大显身手的时刻了:研究团队为BCE相机配备了一个三阶段深度学习系统。

第一阶段采用YOLOv5神经网络进行目标检测和三维定位。该网络接收BCE相机采集的3040×3040×3像素原始图像,迅速在纷乱的信号中锁定目标。网络将检测到的目标在二维图像中的中心坐标(xc, yc)和尺寸(w),通过数学变换转换为三维极坐标系统中的方位角(α)、方位角(β)和距离(R)。这种转换考虑了BCE的球形结构和每个小眼的空间取向,使系统能够在8毫秒内完成目标的空间定位,角度误差小于2.6度,距离误差小于2.3%。

第二阶段是图像重建的核心环节,采使用ResNet34深度神经网络进行图像重建。它面临的艰巨任务是高效地将127个小眼采集的破碎图像片段重新组装成完整清晰的全景图。为系统利用了BCE六边形排列的对称性,就像我们知道雪花图案的六分之一就能推知全貌。网络首先将目标区域旋转到标准位置,提取感兴趣区域并放大到1024×1024像素进行精细处理。通过层层卷积运算和跳跃连接机制,网络学会了如何将模糊的马赛克图像转换成清晰的256×256像素图像。而这个将分散的小眼图像片段融合成连续的430万像素全景图像的整个过程,仅仅耗时77毫秒,

第三阶段使用MobileNetV2轻量级网络进行模式识别。这个网络的设计理念类似于人脑的视觉皮层:通过19个专门的处理模块逐层提取图像特征,从简单的边缘、形状到复杂的模式,就像把一个复杂的识别任务分解成多个简单步骤。网络会输出两组概率分布:一组判断是0-9中的哪个数字,另一组识别是红、绿、蓝、黄、橙中的哪种颜色。实验结果显示,中央视野的数字识别准确率接近完美,即使是因光波导弯曲而略有变形的边缘图像,识别准确率也保持在95%以上。而颜色识别更是接近100%的准确率,充分证明了这套视觉系统的可靠性。

在一项实验中,研究人员让一个标有数字8的目标沿着螺旋轨迹快速移动,同时在另一处放置了静止的数字0。BCE相机不仅能同时追踪两个目标,还能准确重建它们的图像,定位误差仅为2.3%。

传统单反镜头120°视场已是极限,转身时便错过半个世界。而BCE的165°×360°的全景天眼,如同蜻蜓悬停时同时洞察前、后、上、下的威胁。在反应速度上,整个系统从捕捉到识别仅需90毫秒,比你读完这句话还快。相比之下,专业单反的自动对焦系统在面对快速移动的多个目标时,仍会陷入选择困难症。体积对比更是悬殊。一台单反相机仅机身就重有公斤级,而BCE相机的0.8立方厘米体积,却集成了完整的成像、处理和识别系统。虽然画质上目前的BCE相机确实还无法与几千万像素的全画幅单反相提并论,但这个仅有方糖大小的智能虫眼,可能正是打开未来视觉技术大门的钥匙。

参考文献

Yan Long et al. ,Seeing through arthropod eyes: An AI-assisted, biomimetic approach for high-resolution, multi-task imaging.Sci. Adv.11,eadt3505(2025).

本文为科普中国·创作培育计划扶持作品

出品丨中国科协科普部

监制丨中国科学技术出版社有限公司、北京中科星河文化传媒有限公司

作者丨蔡文垂 中国科学院大学博士研究生

审核丨孙明轩 上海工程技术大学 教授

来源: 论文

科普中国公众号

科普中国公众号

科普中国微博

科普中国微博

帮助

帮助

蔡文垂

蔡文垂