一些近视人士也许会发现一个奇妙的现象,在和别人说话的时候,如果摘下了眼镜,视线模糊的同时,声音好像也变得含混不清了。这是不是意味着,人的视觉也能“听见”东西?

其实差不多真是这样!我们的眼睛是可以帮助我们“听见”东西的,也就是视觉可以辅助听觉。

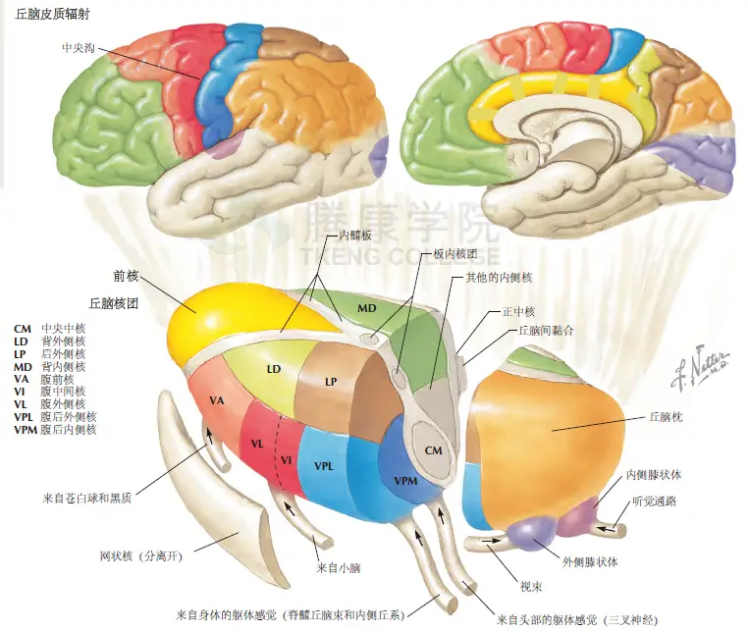

我们的大脑其实是一个多感觉系统协同工作的系统,不同的感觉通道(如视觉、听觉、触觉、嗅觉和味觉)之间并不是彼此孤立的,大脑中的神经网络是高度连通的,这些感觉区域之间存在大量的交互连接。例如,颞叶负责听觉处理,枕叶负责视觉处理,而这些区域之间有丰富的神经纤维可以传递信息和协调活动。它们提供各自的信息,大脑将这些信息融合,从而增强感知的准确性和丰富性。[1]

研究人员通过大脑成像技术(如功能性磁共振成像fMRI)和电生理记录,观察到这rId8些区域在多感觉刺激下的动态活动。我们还是以视听场景为例:

当视觉和听觉信息同步出现时,位于位于枕叶的视觉皮层会有明显的活跃,这是视觉信息处理的第一站,负责处理基本的视觉特征,如形状、颜色、运动。位于颞叶的听觉皮层也会有明显的活跃,它负责处理听觉信息的初级特征,如频率和音量。fMRI显示听觉皮层的活动不仅仅是处理声音信息,还会响应和视觉信息同时出现的刺激。

而在这个过程中,上颞沟(STS)是一个重要的多感觉整合区域,特别是在视听整合中。上颞沟既接受来自初级视觉皮层和初级听觉皮层的输入,又与其他高级皮层区域相连。通过神经成像研究(如功能性磁共振成像fMRI和正电子发射断层扫描PET),发现上颞沟在处理同时出现的视觉和听觉信息时展示出高度神经活动。也就是说,当视觉信息与听觉信号同步出现时,上颞沟能够通过比对这些信号来实现两种感觉的整合。例如,当一个人看到和听到一个人说话时,上颞沟会将视觉的嘴部运动和听觉的语音信号结合,增强对语言的理解。

大脑“合成”听觉的奇妙现象(麦格克效应)

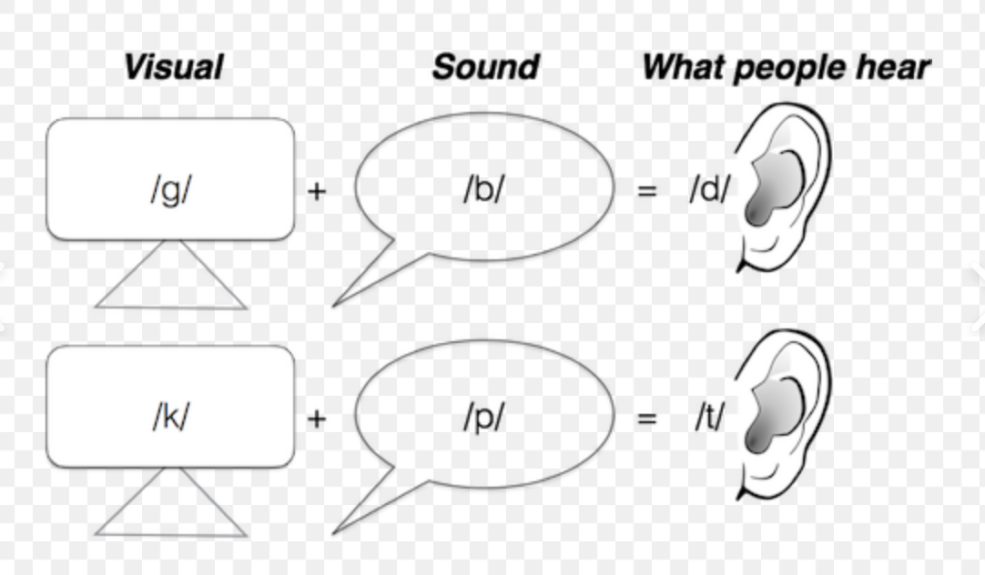

像这样视觉和听觉之间的整合还会出现一个经典的心理学现象,叫做麦格克效应。这个现象首次在1976年被哈里·麦格克(Harry McGurk)和约翰·麦克唐纳(John MacDonald)发现,这个实验中记录,参与者看到一个人嘴部发“ga”的口型,但听到的是“ba”的声音时,他们常常会报告听到的是“da”或其他第三种声音。[2][3]

这一效应表明,当视觉和听觉信息不一致时,人们会产生一种融合的感知经验,有时候人的听觉还会受到视觉的影响,产生错误的认知结果。这一效应揭示了视觉在语音感知中的重要作用,以及大脑整合不同感觉信息的复杂机制。

麦格克效应的产生也来自于多感觉整合机制。大脑中的上颞沟(Superior Temporal Sulcus,STS)和前额叶皮层(Prefrontal Cortex)负责整合来自视听通道的信息。麦格克效应表明,当两种感觉信息(视觉和听觉)存在冲突时,大脑会尝试合理化和融合这些信息,形成一致的感知体验。[4]

这个现象能够很明确说明,我们的听觉并不单纯来自于听觉通道,而是大脑“合成”的结果。具体来说,当眼睛看到一个语音动作,耳朵听到不同的语音信号时,大脑会混合这些信息,导致感知到的语音其实既不是完全基于视觉,也不是完全基于听觉,而是两者的某种组合。这种融合感知的过程表明视觉在某些情况下可以比听觉更能影响我们对语音的感知。

那么,和不同的人说话是否会影响视听效果呢?

其实还真的会。比如和熟悉的人说话以及和不熟悉的人说话,产生的麦格克效应也不同。

说话人脸的熟悉程度也会影响我们的认知,有研究发现,如果实验者对说话的人脸较为熟悉的话,麦格克效应则较弱,也就是我们的听觉更不容易受到视觉的影响。反之,如果对不熟悉的人说话,则更需要调动视觉来理解对方更所说的内容,麦格克效应更强。[5]

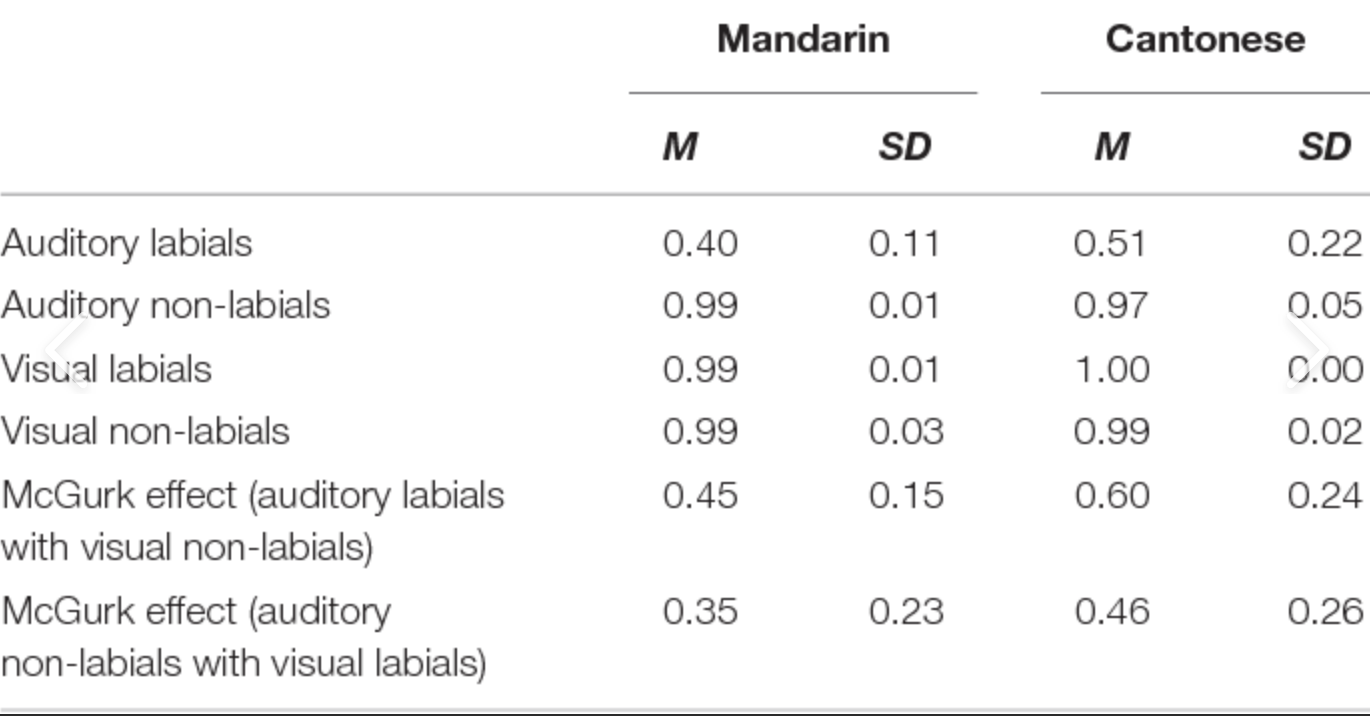

不同语言使用者的人对话中产生的麦格克效应也不同。因为不同语言的音素结构和发音规则有所不同,这可能也影响麦格克效应。例如,一些语言可能有更多的双辅音或者复杂辅音发音,这些复杂的语音成分可能使得视觉信息在语音感知中的作用更为显著。比如粤语和普通话相比,麦格克效应就更强,也就意味着语言使用者更依赖于视觉信息。

不同国家人与人之间的交流文化也会影响麦格克效应。比如许多亚洲文化(如日本、韩国)比较强调对话过程中对面部表情和肢体语言的解读,这可能使得亚洲说话者更依赖视觉信息进行语音理解。相比之下,一些西方文化可能更侧重于准确的语音传达,从而在麦格克效应实验中对视觉信息的依赖度较低。

理解视听整合的现象有什么意义?

了解人类大脑视听整合对于听觉背后的机制,可以也有助于在人工智能领域利用这一点。比如开发多模态的语音识别系统,在语音识别中结合视觉信息,可以提高系统在嘈杂环境中的识别准确率。

同时,在为听力障碍者设计的助听设备里也可以应用这一点,如果能结合视觉信息,将大大改善用户的语音理解能力。例如通过结合唇形读取技术,可以补偿部分听觉信息的缺失。

当然,理解视听整合也能帮助我们解决日常问题,比如帮助我们理解“听不清”背后的复杂机制,这样下次听不清别人说话的时候,不一定要怀疑自己“聋了”(也可能是因为需要配副新眼镜了)。

参考资料:

[1] Stein B E, Stanford T R. Multisensory integration: current issues from the perspective of the single neuron[J]. Nature reviews neuroscience, 2008, 9(4): 255-266.

[2] https://www.youtube.com/watch?v=jtsfidRq2tw

[3] McGurk H, MacDonald J. Hearing lips and seeing voices[J]. Nature, 1976, 264(5588): 746-748.

[4] Nath A R, Beauchamp M S. A neural basis for interindividual differences in the McGurk effect, a multisensory speech illusion[J]. Neuroimage, 2012, 59(1): 781-787.

[5] Walker S, Bruce V, O’Malley C. Facial identity and facial speech processing: Familiar faces and voices in the McGurk effect[J]. Perception & Psychophysics, 1995, 57(8): 1124-1133.

[6] Combining Behavioral and ERP Methodologies to Investigate the Differences Between McGurk Effects Demonstrated by Cantonese and Mandarin Speakers

作者:乌穹(科普创作者)

审核:潘春晨 中国科学技术大学附属第一医院 耳鼻咽喉科 副主任医师

文章由科普中国-创作培育计划出品,转载请注明来源。

来源: 星空计划

内容资源由项目单位提供

科普中国公众号

科普中国公众号

科普中国微博

科普中国微博

帮助

帮助

科普中国创作培育计划

科普中国创作培育计划