随着技术的不断进步

AI应用场景越来越丰富

“一键换脸”,和喜爱的偶像合影

大叔通过AI技术秒变萝莉御姐

“AI孙燕姿”刚“出道”就爆火

……

曾经离我们很遥远的AI

如今正迅速进入大众生活

需要注意的是

骗子也盯上了AI技术

利用它玩起了“真假美猴王”

和你视频对话的可能不是本人

近日

包头警方发布一起利用AI实施电信诈骗的典型案例

“好友”突然打来视频

福州的郭先生在确认过长相和声音后仍被骗

10分钟内被骗走430万元

原来是骗子通过智能AI换脸和拟声技术

佯装好友对他实施了诈骗

幸运的是

接到报警后,福州、包头两地警银迅速启动止付机制

成功止付拦截336.84万元

案件披露后

#AI诈骗正在全国爆发#的话题冲上热搜

引发网友广泛关注

AI诈骗常用手法

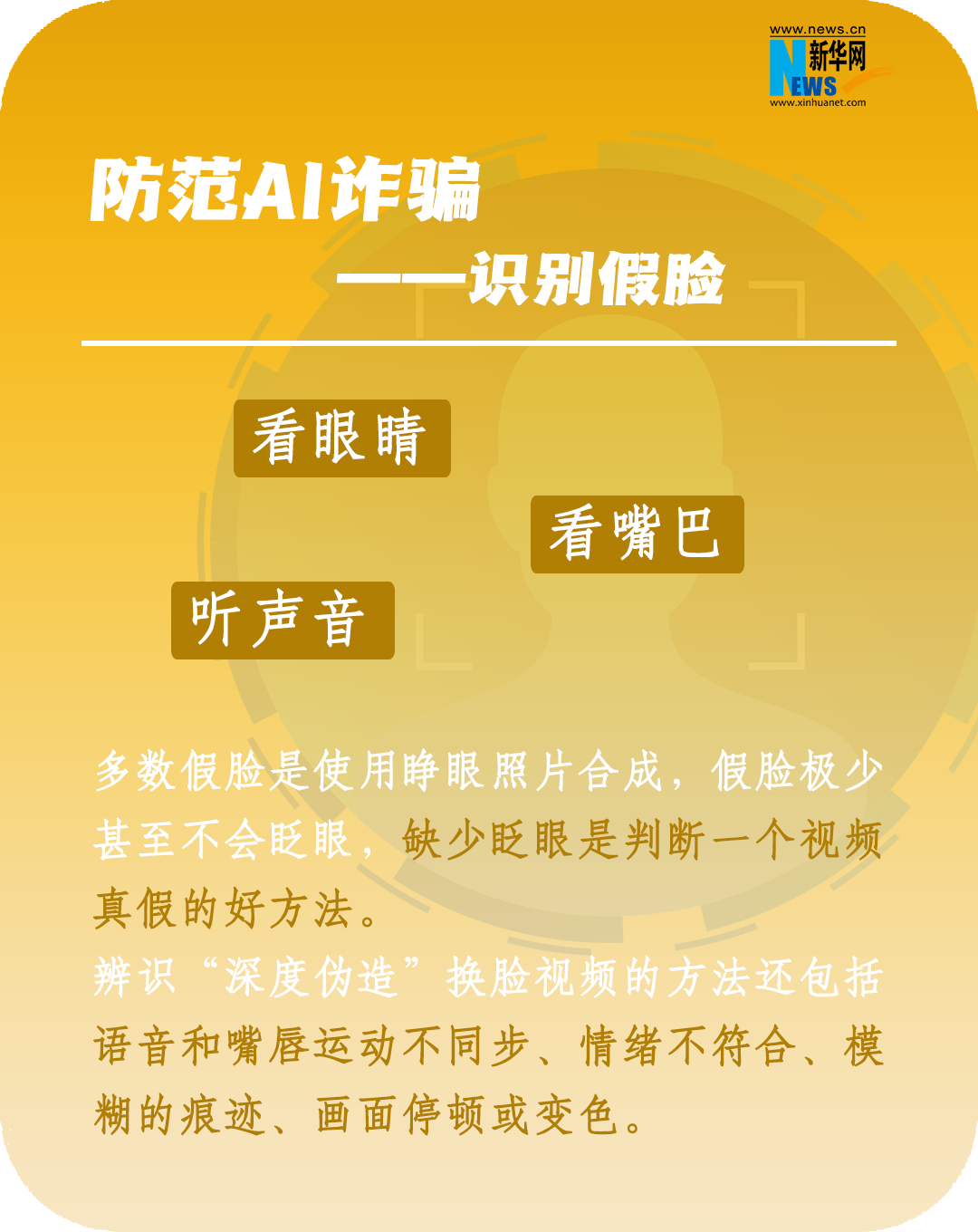

如何防范AI诈骗

那么面对AI换脸诈骗就没辙了吗?

在AI时代,眼见、耳听都不一定为实了,大大增强了迷惑性。运用AI技术,再加上套路和剧本的演绎,这样的诈骗手段,小伙伴们要hold住。

诈骗“魔高一尺”,防范“道高一丈”。

监管先行避免AI“野蛮生长”

需要厘清的是,AI换脸虽然是新事物,但却不存在“监管空白”或“无法可依”的情况。

针对技术手段日益更新的AI诈骗事件,2022年11月25日,国家互联网信息办公室、工业和信息化部、公安部联合发布《互联网信息服务深度合成管理规定》(以下简称规定),自2023年1月10日起施行。规定要求深度合成服务提供者对使用其服务生成或编辑的信息内容,应当添加不影响使用的标识。提供智能对话、合成人声、人脸生成、沉浸式拟真场景等生成或者显著改变信息内容功能的服务的,应当进行显著标识,避免公众混淆或者误认。要求任何组织和个人不得采用技术手段删除、篡改、隐匿相关标识。

今年4月11日,国家网信办起草了《生成式人工智能服务管理办法》(征求意见稿),提出AI内容必须真实准确,其中也明确提到,禁止非法获取、披露、利用个人信息和隐私、商业秘密。

【温馨提示】

使用AI“换脸”及类似软件风险极高,伴随着法律风险和侵权纠纷。“AI换脸技术”即便只是用来搞笑或者制作恶搞照片,也有可能涉及侵犯肖像权、名誉权,造成严重后果的,还可能构成侮辱罪或者诽谤罪。希望大家依法使用该项技术,一旦遇到类似本案中利用“AI换脸技术”实施犯罪行为的,应第一时间固定证据,并及时向司法机关报案。

策划:程立葳

文字:连雨欣

制图:袁羽(漫画除外)

参考资料:公安部网安局微信号、新华社、人民日报、光明日报、东南网等

来源: 新华网

科普中国公众号

科普中国公众号

科普中国微博

科普中国微博

帮助

帮助

科普中国

科普中国